Fabio Bordignon: “Lega e Movimento 5 stelle? Divergenti sì, ma paralleli”

“Lega e Movimento 5 stelle? Divergenti sì, ma paralleli”

Una fotografia del voto del 4 marzo scritta da Bordignon, Ceccarini e Diamanti

Un’Italia giallo – blu, quella che si configura dopo le politiche del 4 marzo, a trazione leghista al centro – nord e con una forte affermazione del Movimento 5 stelle al centro – sud. Due insicurezze opposte ma complementari, una economica, connessa alla crisi, una culturale, legata alle migrazioni. Una diversa distribuzione delle paure, tra Lega e M5s, simmetriche ma speculari. Poi, populismo come opposizione tra popolo “puro” ed élite, soprattutto politiche, corrotte. Sovranismo come sinonimo di nazionalismo, oppure inteso nel senso di protesta, sia per problemi interni, come le migrazioni, che esterni, come l’ingerenza nello stato/nazione degli organismi sovranazionali. Inoltre, un modo di trovare le informazioni sulla campagna elettorale soprattutto attraverso la TV, ma anche, in modo preponderante negli under 30, attraverso siti Internet e social media, mentre “tiene” la comunicazione interpersonale. Poi, un’“affinità elettiva” tra Movimento 5 stelle e Lega, per cui un terzo dei loro elettori si dicono “attratti” dall’altro partito. Inoltre, una divisione in tipologie di elettori che vede i “perdenti della globalizzazione” soprattutto nei partiti vincenti, mentre il PD “macina” la tipologia opposta, quella dei “vincitori della globalizzazione”. Infine, la perdita di legittimazione dei partiti che porta ad una domanda di democrazia diretta attraverso i referendum, e ad una richiesta dell’uomo forte al governo. Dove porterà tutto questo? Forse a una leadership del centro – destra con a capo Salvini dopo nuove elezioni, ma senz’altro dopo le europee del 2019. Sono queste le parole di Fabio Bordignon, docente di Scienza politica all’Università di Urbino “Carlo Bo” e ricercatore di Demos & Pi, nell’illustrare il recente Le divergenze parallele, pubblicato per Laterza e scritto in tandem con Luigi Ceccarini e Ilvo Diamanti.

Un’Italia giallo – blu, quella che si configura dopo le politiche del 4 marzo, a trazione leghista al centro – nord e con una forte affermazione del Movimento 5 stelle al centro – sud. Due insicurezze opposte ma complementari, una economica, connessa alla crisi, una culturale, legata alle migrazioni. Una diversa distribuzione delle paure, tra Lega e M5s, simmetriche ma speculari. Poi, populismo come opposizione tra popolo “puro” ed élite, soprattutto politiche, corrotte. Sovranismo come sinonimo di nazionalismo, oppure inteso nel senso di protesta, sia per problemi interni, come le migrazioni, che esterni, come l’ingerenza nello stato/nazione degli organismi sovranazionali. Inoltre, un modo di trovare le informazioni sulla campagna elettorale soprattutto attraverso la TV, ma anche, in modo preponderante negli under 30, attraverso siti Internet e social media, mentre “tiene” la comunicazione interpersonale. Poi, un’“affinità elettiva” tra Movimento 5 stelle e Lega, per cui un terzo dei loro elettori si dicono “attratti” dall’altro partito. Inoltre, una divisione in tipologie di elettori che vede i “perdenti della globalizzazione” soprattutto nei partiti vincenti, mentre il PD “macina” la tipologia opposta, quella dei “vincitori della globalizzazione”. Infine, la perdita di legittimazione dei partiti che porta ad una domanda di democrazia diretta attraverso i referendum, e ad una richiesta dell’uomo forte al governo. Dove porterà tutto questo? Forse a una leadership del centro – destra con a capo Salvini dopo nuove elezioni, ma senz’altro dopo le europee del 2019. Sono queste le parole di Fabio Bordignon, docente di Scienza politica all’Università di Urbino “Carlo Bo” e ricercatore di Demos & Pi, nell’illustrare il recente Le divergenze parallele, pubblicato per Laterza e scritto in tandem con Luigi Ceccarini e Ilvo Diamanti.

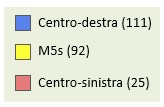

Le Politiche del 4 marzo 2018 hanno delineato, come si evince dalla Tabella 1, un’immagine dell’Italia giallo – blu, contro quella a tre colori (blu, rossa, gialla), sostanzialmente tripolare, delle Politiche del 2013. Come mai questo cambiamento?

Tabella 1

Un cambiamento nel senso della continuità, perché l’assetto del sistema politico è ancora tripolare, tuttavia con due poli, Lega e Movimento 5 stelle, preponderanti rispetto al terzo, cioè il centro – sinistra. Il M5s, che aveva dato il segno alle elezioni politiche precedenti, si conferma soggetto nazionale, ma il suo impianto territoriale si sbilancia significativamente verso il sud e le isole (zona gialla). Dall’altro lato la Lega di Salvini, che riesce nell’impresa di delocalizzare il localismo (zona blu). Questo blu del centro – destra è diverso da quello del 2013, in quanto è il blu scelto come colore dalla Lega, e prevale nettamente all’interno della coalizione. Il suo riferimento territoriale non è più costituito dal Nord, dalla Padania con i suoi riferimenti simbolici (il verde), ma dall’Italia secondo una prospettiva nazionale o, secondo alcuni, nazionalista o sovranista.

Cosa si intende per populismo, che è stato la parola – chiave di queste elezioni insieme a sovranismo? Si può parlare di un populismo di destra (Lega) e di uno di sinistra (Movimento 5 stelle)?

Per populismo s’intende un discorso politico che vede una presentazione dicotomica della realtà politica che distingue tra popolo inteso come popolo portatore di valori positivi da un lato, e dall’altro le èlite considerate come soggetti corrotti. Questo, che è il nucleo ultimo del populismo, ha a che fare con la definizione stessa di democrazia, nel senso che il populismo non fa altro che evocare il mito di una democrazia ideale, intesa come autogoverno del popolo, e allo stesso tempo puntare il dito contro i vizi della democrazia nel modo in cui concretamente funziona. Se la democrazia come la conosciamo nella fase moderna, traccia una linea di demarcazione tra titolarità del potere politico e suo esercizio, il populismo cancella questa linea di distinzione e richiama l’idea di un governo rimesso completamente nelle mani del popolo. E l’idea di sovranità collegata a questo tipo di proposta può essere vista sia in riferimento all’esercizio del potere all’interno dello stato nazionale, sia anche alle dinamiche che attengono al rapporti tra stati. Questo spiega perché tutti i soggetti che oggi definiamo come populisti o sovranisti sono allo stesso tempo, se non antieuropei, euroscettici, in quanto sottolineano il ruolo esercitato da organismi sovranazionali nel sottrarre spazi di manovra ai veri stati nazionali. In questo senso poi esistono sfumature in parte ricollegabili alle tradizionali categorie politiche di destra e sinistra. La Lega è associabile a quello che è un populismo di destra, che ha una tradizione molto più lunga sulla scena europea, mentre farei più fatica a parlare, nel caso del M5s, di populismo di sinistra: piuttosto parlerei di un soggetto politico che mixa al proprio interno elementi di populismo sia di destra che di sinistra.

Per quanto riguarda il sovranismo, alcuni ritengono che ci si possa sbarazzare di questa categoria, sostituendola invece con la vecchia categoria del nazionalismo. Tuttavia, ho l’impressione che oggi i soggetti che si rifanno a questa prospettiva siano in parte diversi dai vecchi attori nazionalisti, in quanto le loro proposte non riguardano tanto l’esaltazione dell’identità nazionale in contrapposizione ad altre. Certo, c’è anche questo, ma tuttavia questa prospettiva concerne la critica a dinamiche che attengono sia ad una dimensione interna, cioè a ciò che avviene all’interno dei singoli stati, sia a una dimensione sovranazionale, che depriva il popolo delle proprie prerogative e del proprio ruolo. Quindi la migrazione nell’accezione più usuale viene vista in senso critico, ma c’è anche un altro tipo di migrazione che è criticata dalla prospettiva sovranista, ossia quella del potere dalla dimensione nazionale a quella sovranazionale. In questo senso c’è una critica molto forte degli attori economici che limitano gli ambiti di manovra degli stati nazionali, ma anche, come dicevo prima, del ruolo delle istituzioni sovranazionali che deprivano il popolo della propria sovranità. Questo tipo di approccio spiega anche perché populismo e sovranismo s’incontrano sullo stesso terreno.

Come si sono informati gli elettori italiani (v. Tabella 2)? È vero che i social media stanno superando, nelle fasce più giovani (18 – 29), anche la TV?

Tabella 2

| POLITICHE 2018: LE FONTI DI INFORMAZIONE

Con che frequenza, nel mese precedente il voto, lei ha ricevuto informazioni sulla campagna elettorale per le elezioni politiche dalle seguenti fonti? (v. %) |

|

| Fonte: Osservatorio Elettorale Demos-LaPolis (Univ. di Urbino), Marzo 2018 (base:1.503 casi) |

La televisione rimane assolutamente predominante rispetto a tutti gli altri mezzi: l’88% degli intervistati dice che si è informato attraverso essa, e questo tipo di dato è strutturale e non cambia. È vero però che i canali che riguardano il web sono fortemente cresciuti dal punto di vista della loro presenza. Nel 2018 il 53% della popolazione in età di voto dichiara di essersi informata attraverso questi canali, e c’è una crescita di 30 punti percentuali se mettiamo a confronto il dato di quest’anno con quello delle politiche del 2008. Tuttavia, se noi isoliamo la componente dei più giovani, la rete ha già superato la TV: oltre il 90% degli under 30 afferma infatti di essersi formato un’opinione politica attraverso questo tipo di canale.

Christopher Cepernich (Università di Torino) sostiene che la campagna porta – a porta è ancora un desideratum In Italia, mentre ha fatto la fortuna di Obama. Quanto da lui detto mi sembra confermato dai vostri dati…

Sì: si parla di una dinamica di lungo periodo che riguarderebbe l’americanizzazione della politica italiana. Tuttavia, ciò sembra essere in contraddizione rispetto ad alcune modalità di conduzione delle campagne elettorali USA, che riscoprono alcune modalità di azione tradizionali che invece in Italia sono state abbandonate negli ultimi anni. Se guardiamo infatti alle modalità più tradizionali rilevate dai nostri dati, quali le informazioni attraverso manifesti elettorali, i depliant, le manifestazioni politiche a cui gli intervistati hanno partecipato o il contatto diretto con i candidati, si tratta di percentuali molto esigue. In particolare, la componente che afferma di essere entrata in contatto diretto con un candidato si aggira intorno al 14%, con percentuali significativamente più basse rispetto a quelle degli altri mezzi di comunicazione. Tutto ciò è segnalatore di un trend di lungo periodo che vede la politica sempre più lontana dai luoghi di vita dei cittadini, come diceva appunto Cepernich.

Più in generale, al di là della specifica questione che riguarda il porta – a – porta, rimane scoperta quella che concerne il presidio del territorio, dove però i partiti oggi sembrano del tutto assenti, anche quelli che avevano una lunga tradizione in questo senso.

Al contrario, appare notevole il ruolo della comunicazione interpersonale, che è aumentata di ben dieci punti percentuali rispetto al 2013…

Sì, questo è l’unico dato di tradizione che emerge in modo molto forte nella nostra indagine: il 65% delle persone intervistate dichiara di avere attinto informazioni sulla campagna elettorale dalle reti informali di relazione, quindi attraverso conversazioni con amici, in famiglia o con colleghi. Questo ci dice come non necessariamente tali informazioni politiche passano attraverso i media. Allo stesso tempo, però, ci segnalano come, nel momento in cui i partiti devono intercettare forme di maggiore presenza sul territorio, queste devono passare attraverso canali più informali che non si traducano nelle appartenenze formali come quelle del passato. C’è quindi bisogno di innovazione dal punto di vista del repertorio d’azione, come del resto in parte hanno fatto, stanno facendo, i vincitori delle ultime elezioni.

Il vostro libro si intitola Le divergenze parallele, cioè le affinità – differenze complementari tra il partito di Di Maio e quello di Salvini. Tutto ciò è confermato anche dalle “affinità” dei due elettorati verso i rispettivi alleati (v. Tabella 3)?

Tabella 3

| LEGA-M5S: LE AFFINITA’ ELETTIVE

Mi può dire quanto si sente vicino ai seguenti partiti? (v. % di quanti si sentono “molto o abbastanza vicini”, tra i simpatizzanti di ciascun partito) |

|||

|

|

||

| Fonte: Osservatorio Elettorale Demos-LaPolis (Univ. di Urbino), Marzo 2018 (base:1.503 casi) | |||

Sì, ci sono molti elementi che ci portano a sottolineare da un lato la diversità di questi soggetti politici, dall’altro però anche la loro parziale vicinanza. Questo lo si vede dalle simpatie reciproche tra gli elettorati o tra i simpatizzanti delle due formazioni. Quasi quattro su dieci tra i simpatizzanti del partito di Salvini esprimono simpatie per il M5s (39%) e in modo del tutto speculare il 35% dei simpatizzanti del M5s vedono con favore la Lega. Esistono pertanto tra le due formazioni quelle che abbiamo chiamato “affinità elettive”, che spiegano la convergenza o le “divergenze parallele” all’indomani del voto. Questo sentimento di reciproca vicinanza si basa sul fatto che entrambi i partiti (o movimenti) attingono allo stesso bacino di malessere che ha fortemente caratterizzato le ultime elezioni. In particolare, esso ha una natura duale. Infatti si può collegare da un lato a fattori di tipo economico, riconducibili agli effetti della crisi ancora fortemente visibili in larghe componenti della società, e dall’altro a un malessere di tipo culturale, legato al fenomeno delle migrazioni e della presenza straniera sul territorio. Questi due elementi di crisi hanno contribuito ad annaffiare le radici dei due movimenti, consentendo loro un avvicinamento, tradottosi nel contratto di governo alla base dell’attuale governo Conte.

Luigi Ceccarini, parlando del 4 marzo, tratteggiava quattro tipologie di votanti: i vincitori della globalizzazione, i perdenti della globalizzazione (tipi “puri”), i vincitori comunitari e i perdenti cosmopoliti (tipi “misti”). Come si distribuiscono tra i quattro partiti maggiori (PD, FI, Lega, M5s)?

Questa è una tipologia che deriva dal tentativo di incrociare tra di loro le due dimensioni che citavo in precedenza, cioè da un lato un grado di soddisfazione/insoddisfazione nei confronti delle condizioni economiche, e dall’altro una propensione ad una società aperta contro una predilezione verso una comunitaria, cioè chiusa rispetto alle dinamiche globali. Entrambe possono essere viste come riflesso delle dinamiche globali e delle conseguenze che esse producono sui cittadini. Ceccarini ha incrociato queste due dimensioni andando ad individuare quattro tipi, e cioè i vincitori della globalizzazione e i perdenti della globalizzazione. Questi ultimi sono quelli che combinano insoddisfazione verso il quadro economico (personale o familiare) e un orientamento verso una società chiusa. Invece i vincitori della globalizzazione sono quelli che in modo esattamente simmetrico e speculare hanno un grado di soddisfazione elevato rispetto alle proprie condizioni economiche e un orientamento cosmopolita verso una società aperta. Ci sono poi altri due tipi misti, definiti vincitori comunitari, cioè persone soddisfatte della loro situazione economica però orientate verso una società chiusa, e perdenti cosmopoliti, che presentano queste caratteristiche in senso inverso.

Per quanto riguarda le loro caratterizzazioni politiche, da un lato Lega e M5s sembrano esprimere un malessere in parte di tipo diverso, nel senso che la insoddisfazione sul versante economico tende a dare come esito politico il movimento di Di Maio, mentre la propensione alla chiusura si traduce in modo più esplicito verso la Lega. Se concentriamo l’attenzione sui perdenti della globalizzazione, e cioè il tipo “puro”, che combina entrambe le forme di tensione rispetto alle dinamiche globali, sia Lega che M5s sono significativamente presenti in questo gruppo. Tutto ciò sottolinea come il processo di formazione del voto per questi due partiti in realtà non segua due percorsi nettamente distinguibili dal punto di vista delle loro radici sociali ma, pur con diverse sfumature, combinino insieme elementi di crisi di tipo diverso ma che configurano un terreno comune.

Quanto a Forza Italia, presenta un profilo ibrido, che per molti versi è sovrapponibile a quello della Lega seppur portando questi tipi di atteggiamenti a livelli meno estremi, e ciò spiega anche perché il partito di Salvini sia oggi l’elemento trainante del centro – destra.

Per ciò che concerne il PD, si tratta di un partito che ha delle caratteristiche diametralmente opposte rispetto a quelle dei vincitori del 4 marzo. In generale vede maggiormente presenti nel suo elettorato elettori soddisfatti dal punto di vista delle loro condizione economica e propensione ad un approccio maggiormente orientato all’apertura. Questo fa sì che, detto in termini molto sintetici, il PD rappresenti i vincitori della globalizzazione però, proprio per questo motivo, non ha potuto figurare tra i vincitori di queste elezioni.

Emerge infine come circa la metà del campione da voi intervistato sia favorevole alla mancanza dei partiti politici a favore dell’istituto del referendum o di un uomo forte al governo. Come valuta tutto questo?

È un ulteriore dato emerso in modo molto forte il 4 marzo: il successo dei partiti vincitori riflette l’incapacità della democrazia di offrire risposte a questioni come l’economia e le migrazioni, però nello stesso tempo tende a produrre un’insoddisfazione più generale nei confronti della democrazia e del suo funzionamento. Tutto ciò si traduce in una domanda di forme più dirette di coinvolgimento del popolo, che passa attraverso ricette alternative: da un lato il coinvolgimento diretto dei cittadini attraverso i referendum, dall’altro tramite un rafforzamento della leadership e della sintonia tra i cittadini e l’uomo forte. Sono percorsi che possono sembrare fortemente lontani tra loro, ma che però sono entrambi riconducibili all’idea di ridurre al minimo il ruolo dei corpi intermedi. Tra questi il principale è rappresentato dai partiti che hanno svolto questo ruolo di filtro tra società e politica in passato, filtro che tende sempre meno ad essere tollerato da parte dei cittadini, che cercano forme più dirette di coinvolgimento e di protagonismo del popolo.

Alla luce di quanto emerso, visti anche i sondaggi che vedono la Lega superare il Movimento 5 stelle, a cosa porterà questa situazione?

Questo ha a che fare con la capacità di Salvini di occupare la scena dopo il 4 marzo e di saper imporre la propria figura in uno scenario incerto proprio come quello. Tutto ciò avviene all’interno di uno scenario che altrove ho definito vicepresidenziale, cioè nel quale la forza della leadership di governo si manifesta attraverso i due vicepresidenti. Tuttavia, tra i due, Salvini si è rivelato più abile nell’occupare la scena. L’evoluzione del consenso verso i due partiti testimonia questo tipo di capacità e ribalta i rapporti di forza iniziali, che davano la Lega al 17%. L’attuale ribaltamento ci dice quanto contino poi i leader e le persone nel determinare l’evoluzione del clima d’opinione e anche degli orientamenti di voto. Ciò potrà avere delle ripercussioni sulle dinamiche interne alla maggioranza nel momento in cui Salvini dovesse essere tentato di capitalizzare questo tipo di consenso attraverso un ritorno alle elezioni. Forse oggi, con gli equilibri attuali, se si tornasse a votare, un centro – destra a trazione leghista sarebbe in grado di conquistare la maggioranza, ma attualmente non vedo avvisaglie di questo almeno fino alle prossime elezioni europee del 2019.

MARIA GRAZIA FALÀ